米Googleは9月29日(現地時間)、Google検索とAI技術について語るイベント「Search On ’21」を開催し、MUM(Multitask Unified Model)による言葉と画像を組み合わせたマルチモーダル検索を披露した。同社はまた、MUMを含むAI技術をGoogle検索に活かす4つの新機能も明らかにした。

Google、AIで情報をより便利に、マルチモーダルによる自然で直観的な検索(マイナビ)

話題のMUM(Multitask Unified Model)とは?

通常であれば複数回の検索が必要になるであろう複雑な質問に対し、様々な角度からアンサーを返してくれる検索アルゴリズムです。MUMは会話調や微妙なニュアンスが含まれる言語理解能力を備えており、なんと画像も理解することができます。

例えば次は○○山登りという検索をすると、その意図を汲んで、正しいギアの選び方に関する記事や動画、画像など適切な検索結果を返してくれるわけです。このように「一言で言えない質問に対し、いかに適切な回答するか」が多言語的AI検索として注目されてきています。

情報の網羅性、俯瞰型と提案型も可能に!

「分からないならググれ!」と言われるほどに、私たちはGoogleの検索窓に知りたいことを打ち込みます。

調べる時にはさらに情報を深堀りすることもあれば、全体を把握するために調べることもある。

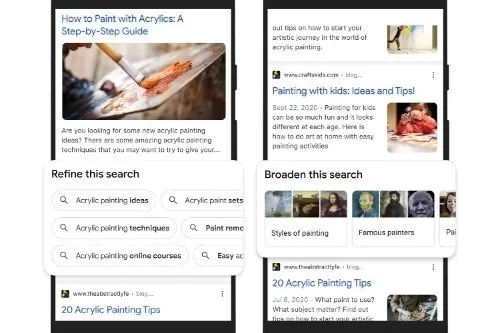

例えば、「アクリルペインティング」という検索に対して、絞り込み(Refine)候補では「アクリルペイント・セット」や「アクリルペインティング・オンラインコース」など、拡大(Broaden)候補では「有名なペインター」「ペインティング・スタイル」などを提案してくれる。

私たちは「自分の知りたいこと」だけでなく、「これも知りたいんじゃない?」「あなたならきっとこれも興味あるよね?」とGoogleのAIによって世界を広げ、深めてもらえるということになります。

私たちが何となく知りたい、まだ言語化できていないものを汲み取り、AIによって提案される世界はもうすぐそこまで来ているということです。